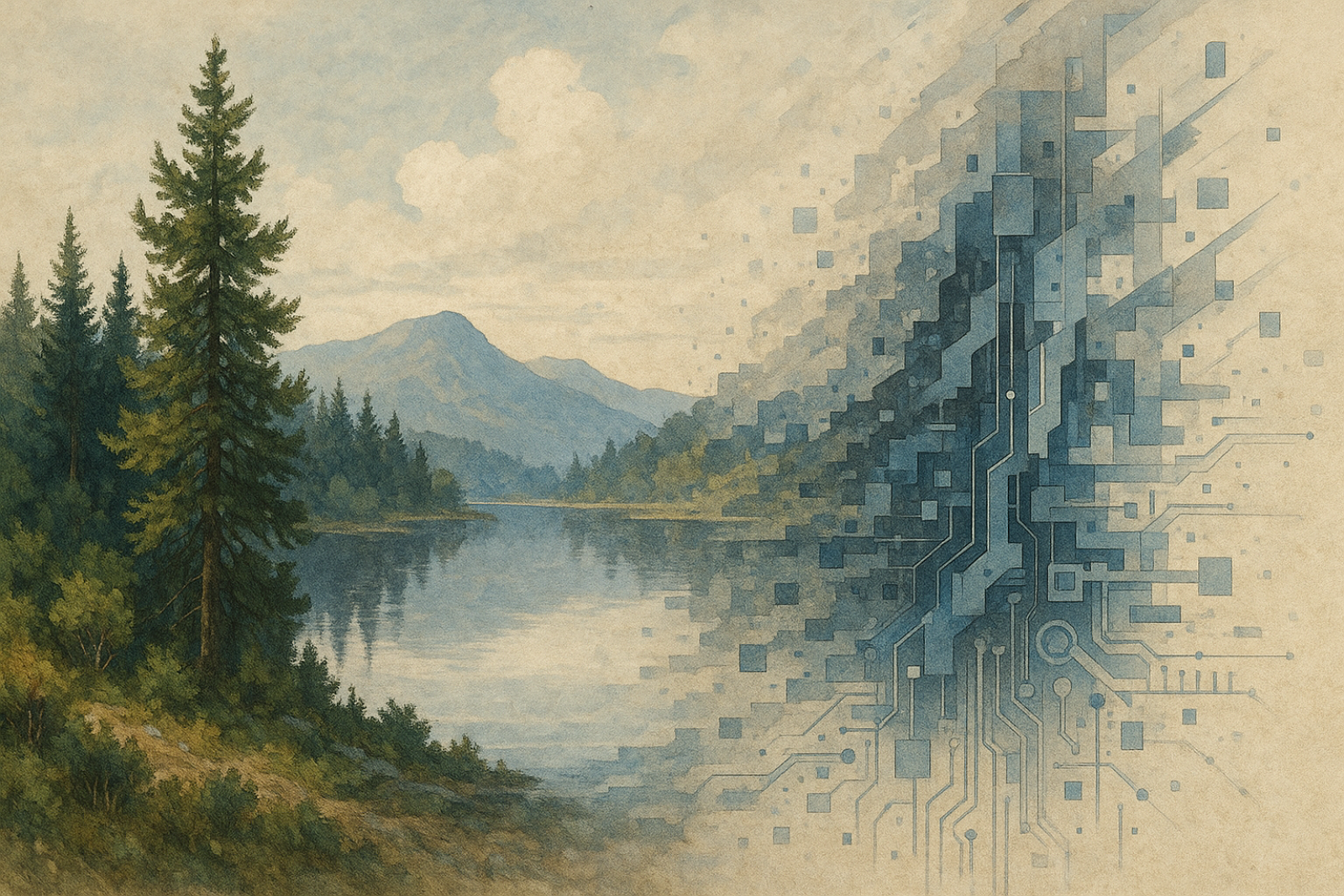

L’intelligenza artificiale generativa sta rivoluzionando profondamente il modo in cui creiamo e utilizziamo le informazioni. Dai testi alle immagini, dai video agli avatar digitali, oggi le macchine sono in grado di generare contenuti simili a quelli prodotti dagli umani, aprendo scenari ricchi di opportunità ma anche di sfide complesse. Tra le più urgenti c’è quella di distinguere i contenuti «sintetizzati» dall’AI.

La diffusione dell’informazione ha sempre accompagnato l’evoluzione tecnologica segnando svolte epocali: dalla stampa a caratteri mobili di Gutenberg, che rese la conoscenza più accessibile, all’avvento di Internet e della digitalizzazione, che hanno dato vita alla società dell’informazione, globale e istantanea. Oggi viviamo un’altra trasformazione: le tecnologie generative, capaci di utilizzare il linguaggio naturale, stanno cambiando il nostro rapporto con l’informazione. Se da un lato offrono nuove potenzialità espressive, dall’altro rendono sempre più difficile distinguere le informazioni «sintetizzate» da quelle create interamente da esseri umani, sollevando nuove sfide che richiedono consapevolezza e strumenti adeguati.

La Cyberspace Administration of China (CAC) ha recentemente promulgato un insieme di prescrizioni denominate Misure per l’identificazione di contenuti sintetici generati dall’intelligenza artificiale, segnando un passo significativo nella regolamentazione delle tecnologie emergenti in ambito digitale. Tali misure, che si inseriscono in un contesto di crescente attenzione globale verso i rischi associati all’uso dell’AI generativa, prevedono due principali modalità di identificazione dei contenuti sintetici: una forma esplicita e una implicita.

L’identificazione esplicita si realizza mediante l’inserimento, nei contenuti generati artificialmente (testi, suoni, immagini ecc.), di marcatori chiaramente percepibili dagli utenti, al fine di rendere trasparente l’origine artificiale dell’output generato. L’identificazione implicita, invece, si basa sull’adozione di tecnologie invisibili all’utente finale, capaci di tracciare l’origine sintetica dei contenuti tramite metadati o codici digitali incorporati nei file.

Se l’identificazione esplicita permette agli utenti di sapere immediatamente se ciò che stanno vedendo o ascoltando è stato generato da una macchina, quella implicita offre un livello di controllo più profondo e tecnico, utile soprattutto per le piattaforme, le autorità e gli sviluppatori nel monitorare e contrastare eventuali abusi.

In un’epoca in cui i contenuti generati con l’intelligenza artificiale sono sempre più indistinguibili da quelli realizzati interamente da esseri umani, le misure adottate dalla CAC vogliono rappresentare un tentativo concreto di fornire strumenti atti ad affrontare questa difficoltà. In effetti, in assenza di meccanismi di tracciabilità e trasparenza, la diffusione incontrollata di contenuti sintetici potrebbe incidere sull’integrità delle informazioni, sulla stabilità dell’ecosistema informativo digitale, minacciando la qualità delle informazioni e la libertà di espressione. In tale prospettiva, la proliferazione non regolamentata di contenuti generati dall’AI solleva rilevanti questioni di natura etica e politica, tra cui la veridicità delle informazioni, la possibilità di distorsione sistematica della percezione collettiva e la compromissione dei presupposti per un confronto pubblico autenticamente pluralista.

La regolazione proposta dalla CAC, sulla consapevolezza che l’intelligenza artificiale generativa rappresenti un asset strategico per la crescita economica e il miglioramento della vita quotidiana, mira a garantire uno standard di trasparenza che permetta agli utenti di identificare i contenuti sintetici per distinguerli da quelli non sintetici. Questa classificazione, questa demarcazione prescinde da qualsiasi obiettivo di accertamento della veridicità dell’informazione, dal momento che i moderni sistemi di intelligenza artificiale operano in modo indipendente rispetto al concetto di verità. L’intento non pare quello di stabilire se un contenuto sia vero o falso, bensì di rendere chiara la sua origine affinché il soggetto destinatario dell’informazione possa riconoscere la natura del messaggio ricevuto.

L’iniziativa è mossa da una forte spinta geopolitica. In effetti, la vulnerabilità che si va a tutelare non è solo una questione tecnica, ma assume una chiara rilevanza politica e sociale: contenuti sintetici non dichiarati tali possono influenzare l’opinione pubblica e il formarsi democratico di un dibattito, ledere la reputazione di individui e finanche delle istituzioni. Ebbene, pur nella consapevolezza che la regolazione cinese sia espressione di un impianto ideologico e valoriale distante da quello liberaldemocratico occidentale, non si può ignorare come essa rifletta un’urgenza condivisa a livello globale: quella di garantire che le tecnologie emergenti, e in particolare l’intelligenza artificiale generativa, non diventino strumenti di disordine informativo o di destabilizzazione sociale. Il timore che potenze straniere o attori non statali possano sfruttare l’intelligenza artificiale generativa per condurre operazioni di disinformazione, influenzare processi elettorali o destabilizzare il tessuto sociale di altri Paesi, è alla base della crescente attenzione internazionale verso la regolamentazione di questi strumenti.

Già nel 2023 la Cina si è dotata di regole per la gestione dei servizi di intelligenza artificiale generativa, con l’obiettivo che i sistemi di AI debbano conformarsi ai valori fondamentali del socialismo cinese. Questo approccio evidenzia una volontà di controllo ideologico sull’intelligenza artificiale, ma al tempo stesso segnala una consapevolezza, assunta politicamente, della portata trasformativa – e potenzialmente destabilizzante – di queste tecnologie.

Per tali ragioni si può affermare che il loro controllo rappresenta non solo una questione di innovazione ma un elemento chiave nella tutela della sovranità nazionale e nella ridefinizione degli equilibri geopolitici globali. Sappiamo, infatti, che le differenti posizioni politiche che sorreggono le scelte di governance esprimono regole che restano solo formalmente limitate dai confini degli stati nazionali. In particolare, regolamentare l’AI generativa significa dettare regole al di fuori dei confini geografici. Ancora una volta, non è in gioco il primato tecnologico ma la conquista di una leadership geopolitica, grazie allo strumento normativo impiegato per tutelare le singole sovranità.

In questo contesto si inquadra la sfida tecnica tra AI generative e strumenti di identificazione, supportati dall’AI, nella classificazione di contenuti digitalmente creati. Con la mole attesa di contenuti non basterà più il lavoro della comunità sociale e scientifica, che storicamente hanno filtrato le informazioni, ma necessariamente ci affideremo a sistemi per il rilevamento di «tracce digitali» e il filtraggio dei contenuti.

A questi si affiancheranno strumenti e tecnologie per certificare la creatività umana come, ad esempio, Blockchain e firma digitale, necessari per tutelare il valore economico e intellettuale degli artefatti umani.

È prevedibile che a ogni miglioramento nei sistemi di rilevamento corrisponda parallelamente un’evoluzione nei sistemi di generazione, dando luogo a una competizione continua, in cui solo l’AI saprà riconoscere contenuti sintetizzati. Questo scenario prefigura un contesto di AI antagoniste, con il rischio che l’essere umano venga progressivamente emarginato, perda di motivazione, creatività e spirito critico, aprendo le porte a una società in cui l’uomo non sarà più al centro, ma semplice fruitore passivo dei contenuti. Una normativa adeguata al tracciamento a monte dei contenuti, in tal senso, risponde a una esigenza non derogabile.